De plus en plus de sites utilisent des frameworks JavaScript.

Bien que GoogleBot exécute fréquemment le JavaScript, les référenceurs ont rapidement compris qu’il était préférable d’envoyer du code HTML aux robots s’ils voulaient continuer à performer dans les SERP.

Plusieurs solutions techniques avec de subtiles différences sont possibles, mais concrètement cela revient à générer le code JS côté serveur et non côté client afin de disposer du code HTML.

L’application distinguera les robots des visiteurs, et enverra ainsi en fonction du HTML ou du JS. Oui, il s’agit bien de cloaking mais c’est officiellement autorisé par Google dans ce cas. Il s’agira d’un simple cloaking sur user agent.

L’application pourra générer à l’avance ou à la volée des snapshots HTML qui pourraient, par exemple, être mis en cache.

Toutefois, imaginez une seule seconde que votre serveur n’envoie plus le HTML aux robots. C’est toute votre visibilité qui risque de s’effondrer.

Là où c’est assez pervers, c’est que visuellement, il sera impossible de se rendre compte du problème, car votre navigateur continuera d’exécuter JS et votre site de fonctionner.

Comment limiter les risques ?

Attendre la chute des résultats ? Trop risqué

Recetter à la main chaque jour ? Trop chronophage

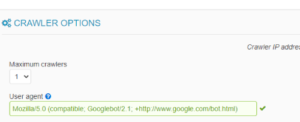

La solution ? Configurez en 2 secondes le robot d’Oseox MONITORING à l’aide du user-agent de GoogleBot afin de servir à notre crawler du HTML.

Notre crawler n’exécutant pas JavaScript, si votre prerender connaît une défaillance, vous allez recevoir automatiquement une notification dans l’heure et ainsi pouvoir intervenir avant même que GoogleBot ne vous en tienne rigueur.